En marketing digital, nous prenons souvent les données analytiques au pied de la lettre. De ce fait, elles influent nos décisions commerciales. En effet, ces données se basent, dans la plupart des cas, sur des informations qui, peut-être, ne devraient pas avoir autant de poids.

Avant de décider comment investir au sein de votre entreprise, chaque point de données doit faire l’objet d’un examen minutieux.

Cet article a donc pour objectif de vous aider à développer une compréhension approfondie des méthodes de collecte de données et de calcul de votre outil avant de commencer à parier sur l’exploitation.

Une analyse toujours faussée

Vous avez sans doute remarqué qu’il est très rare que les données fournies par un canal de marketing individuel (par exemple Facebook Analytics) aient une parité avec celles de votre principal ensemble d’analyses.

Vous serez peut-être surpris d’apprendre que les différents progiciels d’analyse (par exemple Google Analytics vs Adobe Analytics) ont des méthodologies de mesure différentes. C’est-à-dire que la définition d’une session ou d’une visite dans GA n’est pas la même que celle du programme d’analyse anciennement connu sous le nom d’Omniture. Ainsi, même si vous avez installé et configuré les deux de manière similaire, vous verrez probablement des données différentes.

En SEO, c’est probablement la raison pour laquelle Google Analytics et Google Search Console ne correspondent pas aussi bien. En effet, SGC utilise des fichiers logs des requêtes et des clics alors que Google Analytics est un outil de suivi des clics. Les méthodologies de mesure n’ont donc jamais été compatibles.

Dans certains cas, les clients prennent des mesures (sans jeu de mots) qu’ils trouvent par eux-mêmes. Ils mettent en place un système d’analyse précaire qu’ils gèrent de manière autonome. Cela aussi peut introduire des failles supplémentaires dans la discussion sur les mesures. Ce qui est également le cas dans la création de votre propre CMS. Cela peut vous fermer les yeux sur certaines bonnes pratiques.

Quoi qu’il en soit, retenez que les données que vous obtenez de n’importe quel système d’analyse n’ont jamais été à 100% fiables de ce qui se passe sur votre site et ne le seront jamais.

GUIDE GRATUIT

Prévision et anticipation du Retour Sur Investissement pour le référencement naturel (SEO)

Comment fonctionne Analytics et pourquoi est-il faussé ?

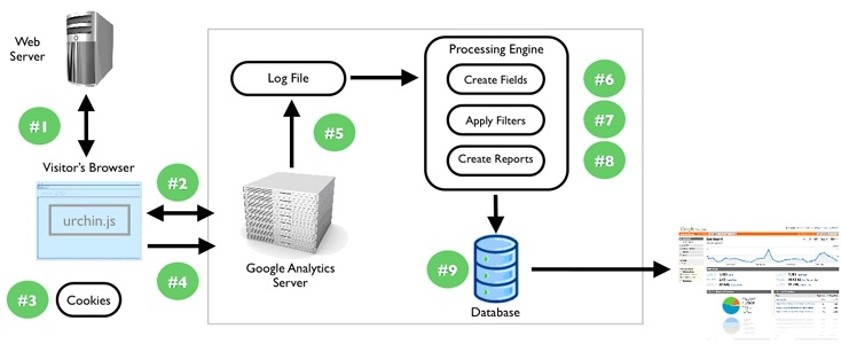

Analytics se présente sous différentes formes, mais il s’agit ici de progiciels d’analyse de parcours de navigation tels que Google Tag Manager ou encore Google Data Studio. Ces outils fonctionnent par le placement d’un extrait de JavaScript sur chaque page web. Une fois que la page charge cet extrait JavaScript, elle renvoie des données sur l’utilisateur et ses comportements à un serveur centralisé. Ce serveur stocke ces informations dans une base de données (Urchin, le prédécesseur de GA utilisait une base de données de la famille SQL) pour l’affichage, l’analyse et l’exportation via une interface sophistiquée.

Chaque outil détermine ce qu’est une session, un utilisateur unique, une vue de page. Vous déterminez ce qu’est un événement et/ou une conversion. Au-delà de cela, ils fonctionnent tous de la même manière.

Les cookies sont généralement utilisés pour déterminer si un utilisateur a déjà été vu ou non et ils agissent comme un mécanisme de stockage. Cela diffère de l’analyse des fichiers logs dans la mesure où il faut que Java Script s’exécute et que le stockage du navigateur fonctionne. Si vous êtes un peu curieux, les fichiers logs sont générés au niveau du serveur et sont une réaction à chaque opération d’accès déclenchée par un agent utilisateur.

En raison de la dépendance du JavaScript de l’analyse du parcours des clics, ils peuvent être perturbés de diverses manières, intentionnelles, accidentelles et malveillantes.

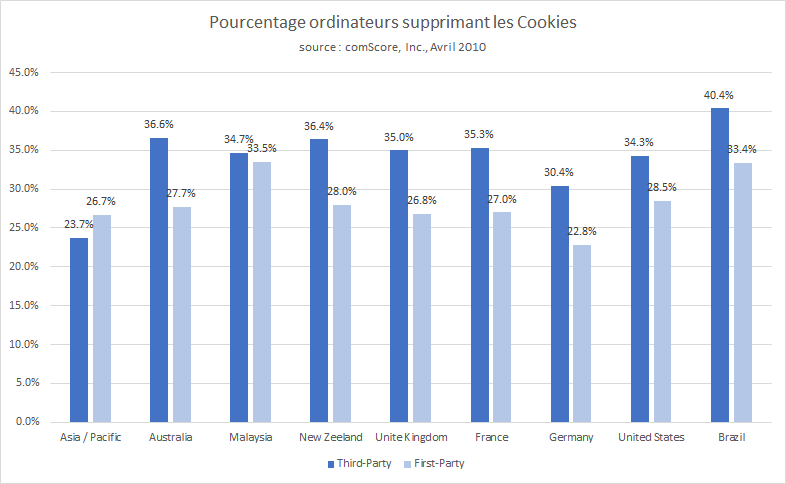

En ce qui concerne l’aspect néfaste, il est en fait assez facile d’injecter des données incorrectes dans GA en tant que tiers. À l’autre bout du spectre, il y a les utilisateurs qui suppriment ou désactivent les cookies (bonjour les règlements de l’UE !), ceux qui désactivent JavaScript ou qui ont des bloqueurs de publicité ou ceux qui n’ont peut-être pas encore mis en liste blanche certaines plateformes d’analyse.

Dans les situations où les connexions sont lentes, les utilisateurs peuvent potentiellement arrêter le chargement de la page avant que l’analyse ne se déclenche.

De ce fait, vos analyses ne reflètent jamais 100 % des utilisateurs ou de leurs comportements. Un certain pourcentage de vos « nouveaux utilisateurs » ou sessions ont toujours été des utilisateurs réguliers ou la même session respectivement. Et un certain pourcentage d’utilisateurs n’a jamais été saisi. Et il est même possible que quelqu’un ait envoyé des données dans votre installation d’analyse à distance pour gonfler ou dégonfler vos performances. Tout cela avant même de considérer l’échantillonnage que fait Google Analytics si vous n’êtes pas sur la version payante

Et, devinez quoi ? Tout est sur le point d’empirer…

Commençons par l’ITP : Intelligent Tracking Prevention

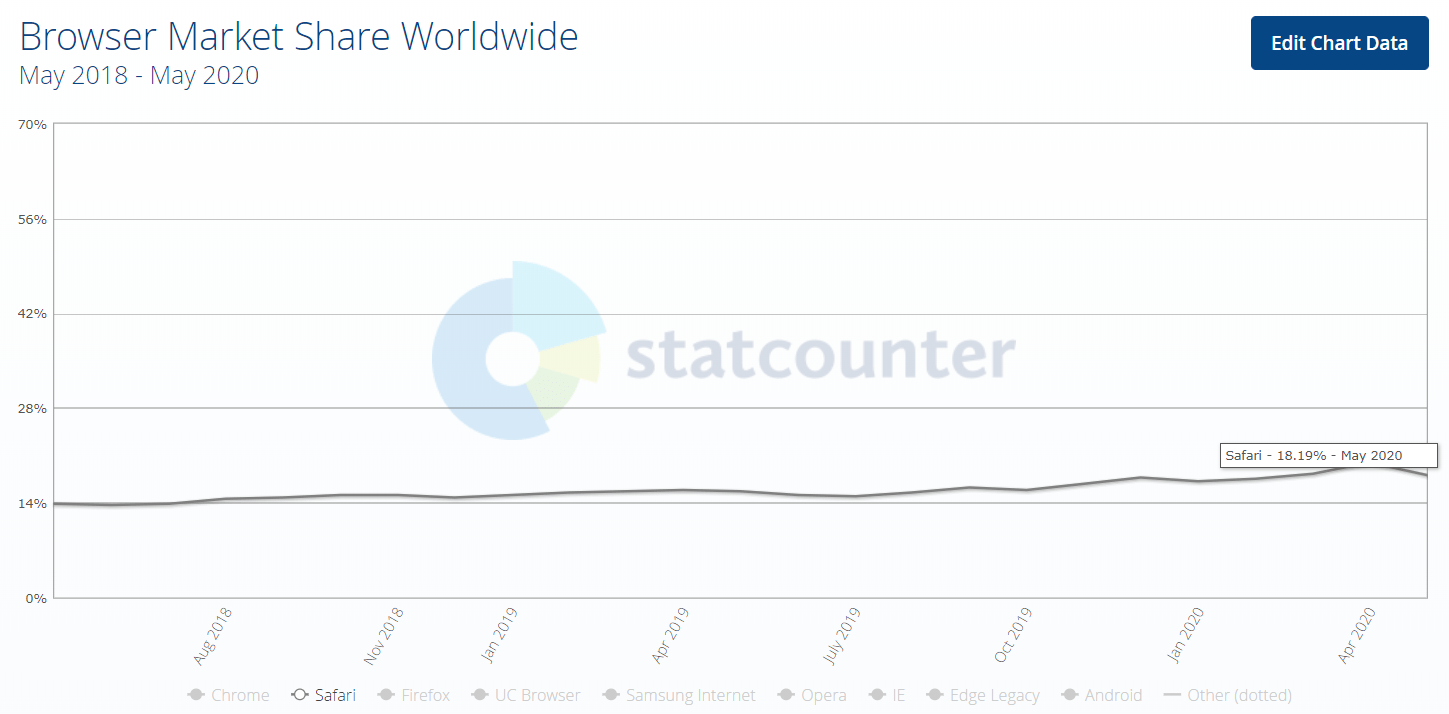

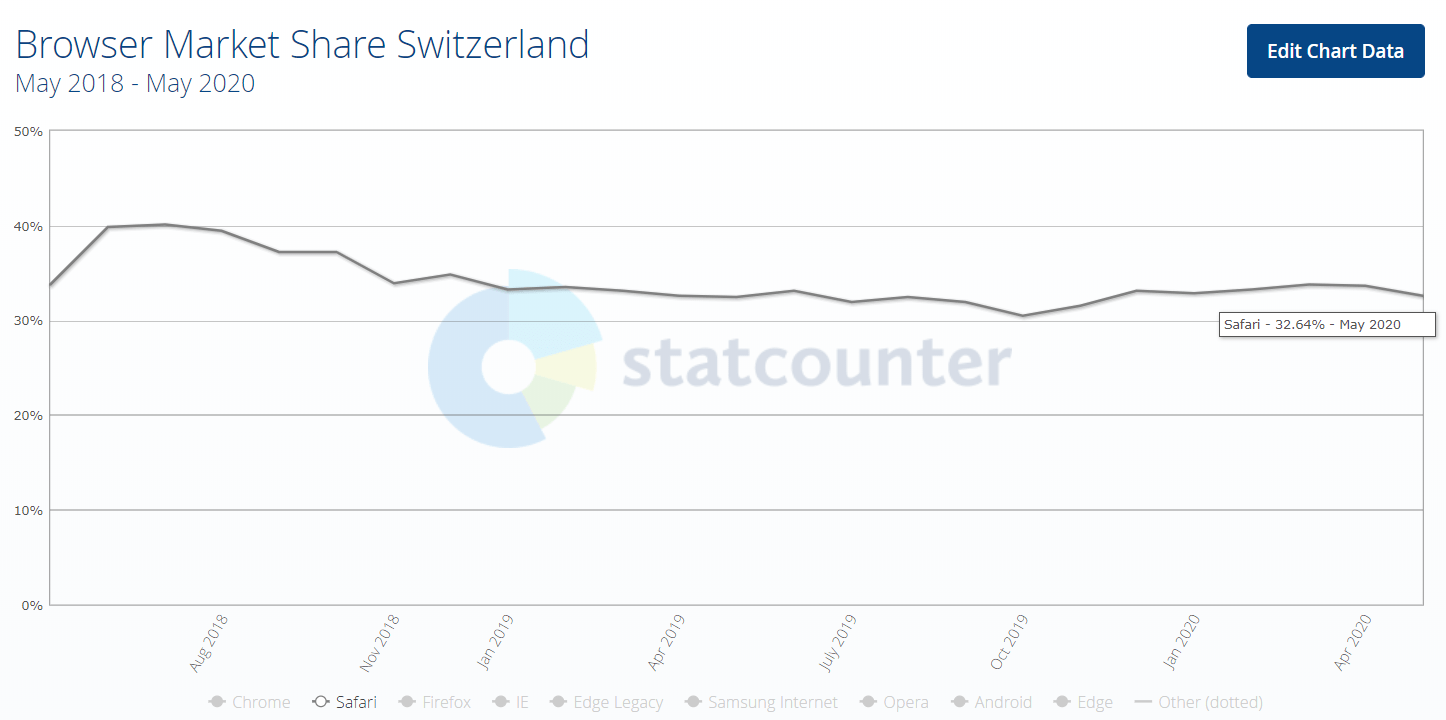

Début 2017, Apple a lancé une initiative qu’ils appellent « Intelligent Tracking Prevention ». Au départ, cette initiative visait à supprimer la capacité des tiers à suivre les utilisateurs sur plusieurs sites. Au fur et à mesure des versions suivantes, elle a évolué vers l’élimination des cookies, même les plus anciens, en limitant leur durée de vie à sept jours. Cela s’applique en particulier à Safari qui, selon gs.statcounter.com, détient 18,19 % des parts de navigateur sur les téléphones portables et les ordinateurs de bureau réunis, dans tout le monde et 32.64% en Suisse.

Là encore, les cookies sont utilisés pour déterminer si un utilisateur a déjà visité le site et pour stocker des informations sur cet utilisateur. Si les cookies ont une expiration de 7 jours, une grande partie de nos renseignements sur les performances sont perdus. Le concept d’une fenêtre de retour en arrière de 90 jours est une conclusion. Le re-ciblage au-delà de 7 jours est mort. En effet, pour un cycle de vente de toute durée réaliste, tout le concept d’attribution en dehors du dernier clic est terminé. Oh, et nous n’avons même pas discuté des implications sur les tests A/B côté client avec des outils comme Optimizely.

Ne vous y trompez pas, ce sera un problème qui se répercutera sur toute la toile et brisera beaucoup de choses. Selon la composition des dispositifs utilisés par votre public pour accéder à votre marque dans votre mix média, cela peut fausser votre capacité à comprendre les performances.

Les experts en marketing avertis utiliseront une combinaison d’empreintes de navigateur et de suivi pour contourner ces nouvelles limites, mais, il s’agit probablement d’une solution à court terme. La solution la plus définitive pour le suivi serait que les utilisateurs restent connectés.

Une connexion permanente place Google et Facebook dans une position unique pour avoir une intelligence plus « précise » que tout autre acteur car ils captent les plus grandes bases d’utilisateurs connectés.

Cependant, à voir si cela ne va pas finalement mettre Google dans l’eau chaude, car leur capacité à contourner les actions de leurs concurrents par le biais de leur écosystème suggère potentiellement un monopole.

Quoi qu’il en soit, l’ITP est sur le point de creuser un grand trou dans vos analyses et les fonctionnalités de votre technologie de marketing en général, surtout si beaucoup de vos utilisateurs utilisent des appareils Apple.

GRPD et chevauchement de la vie privée

Pour les spécialistes du marketing numérique, le règlement général sur la protection des données de l’UE (GRPD) est ou a été une étape préoccupante. Tout le monde s’est empressé de s’y conformer par crainte des amendes que l’UE est prête à imposer. En conséquence, de nombreuses entreprises et services juridiques craignent de suivre et d’utiliser les données de leurs utilisateurs. Dans une certaine mesure, c’est beaucoup de bruit pour pas grand-chose. (Rappelons que nous ne sommes pas ici pour vous donner des conseils juridiques, ni pour vous dire que GRPD ne sert à rien).

Cela étant, le GDPR n’est pas censé être un mécanisme visant à empêcher la collecte de données. Il s’agit plutôt d’un mécanisme visant à décourager les utilisateurs à suivre tout et n’importe quoi de manière injustifiée.

Si vous adhérez à la norme GRPD, vos utilisateurs doivent avoir la possibilité de supprimer de vos systèmes leurs données et les données les concernant. De manière inhérente, cela introduit des trous noirs potentiels dans vos données si un nombre significatif de personnes veulent se supprimer de vos bases de données.

Ces utilisateurs représentent certainement une menace existentielle potentielle pour vos données de trafic, mais peut-être pas aussi importante que d’autres menaces.

Alors, qu’est-ce qu’on fait ?

Tous les problèmes engendrés par ce « faussement » de données analytiques sont potentiellement des coups durs pour tout ce que nous faisons pour suivre les performances. Tout cela suscite une série de questions :

Devons-nous repenser les données sur les performances en général ?

Allons-nous devenir de plus en plus dépendants de solutions basées sur des panels comme ComScore et Hitwise ?

Quel rôle, le cas échéant, les fichiers historiques peuvent-ils jouer pour récupérer certaines informations ?

Les fournisseurs d’accès Internet vont-ils entrer en jeu pour tenter de nous restituer une plus grande partie des données ?

Les spécifications et les solutions d’identité des utilisateurs portables seront-elles davantage adoptées ?

Après tout, la perte du suivi permanent des utilisateurs ne fait qu’augmenter la valeur de la richesse des utilisateurs toujours connectés à Facebook et Google.

Passez en revue les segments du problème

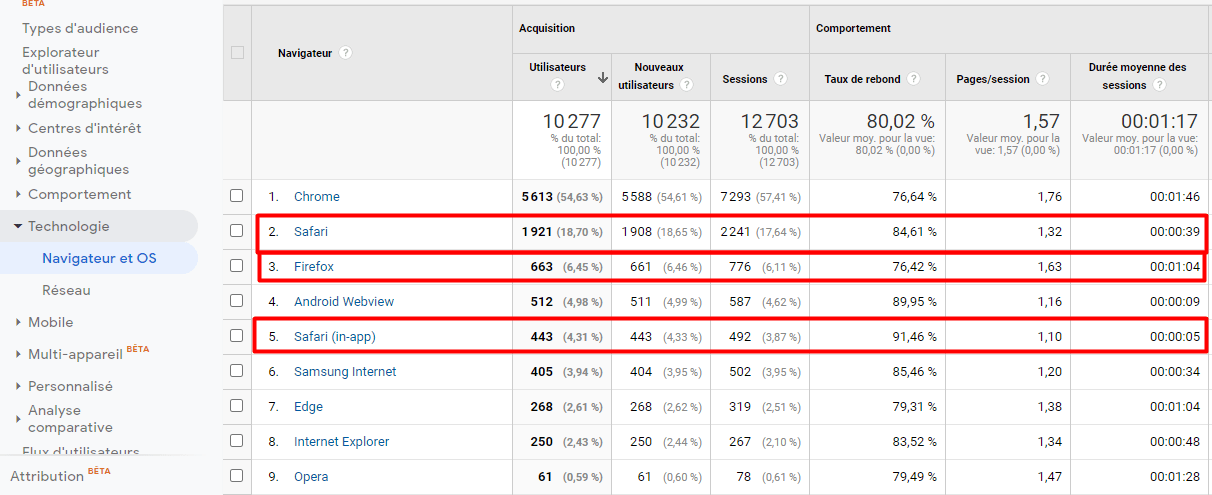

En attendant, vous devriez examiner de quels appareils et agents utilisateurs provient votre trafic. C’est la première étape pour déterminer dans quelle mesure vos données sont à risque. Pour les utilisateurs de Google Analytics, allez dans Audience > Technologie > Navigateur & OS et vérifiez quelle part de votre trafic provient de Safari et Firefox.

Créer des segments pour ces facilitateurs ITP et garder un œil sur la croissance artificielle des segments de nouveaux utilisateurs. Surveillez également l’évolution de vos entonnoirs multicanaux dans le temps.

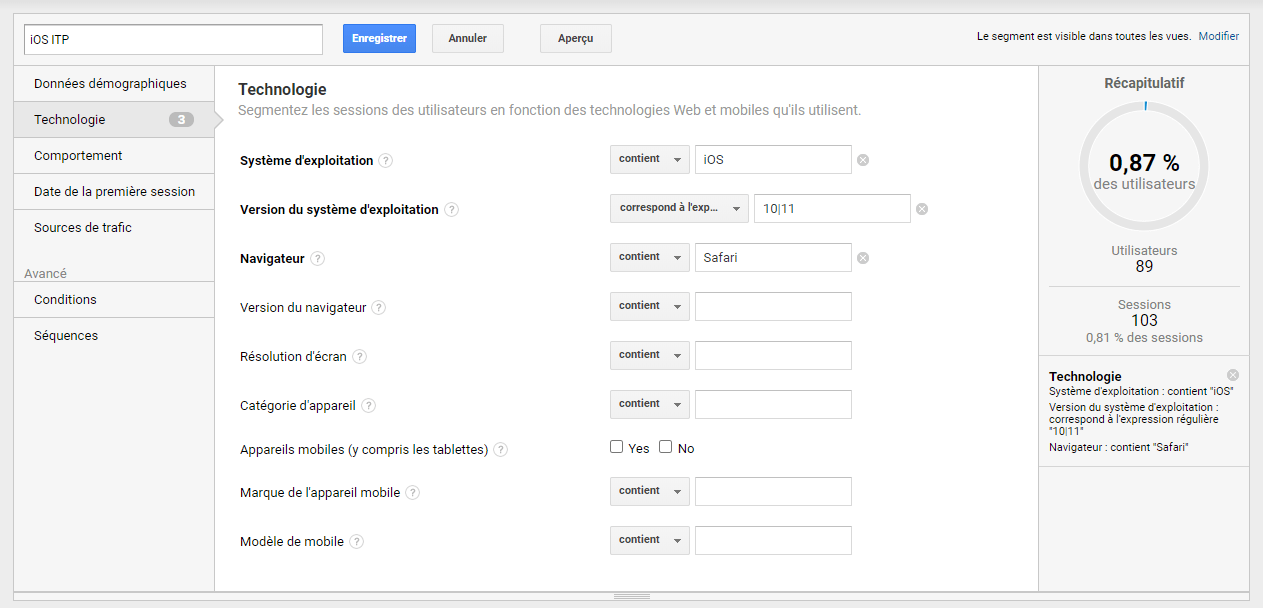

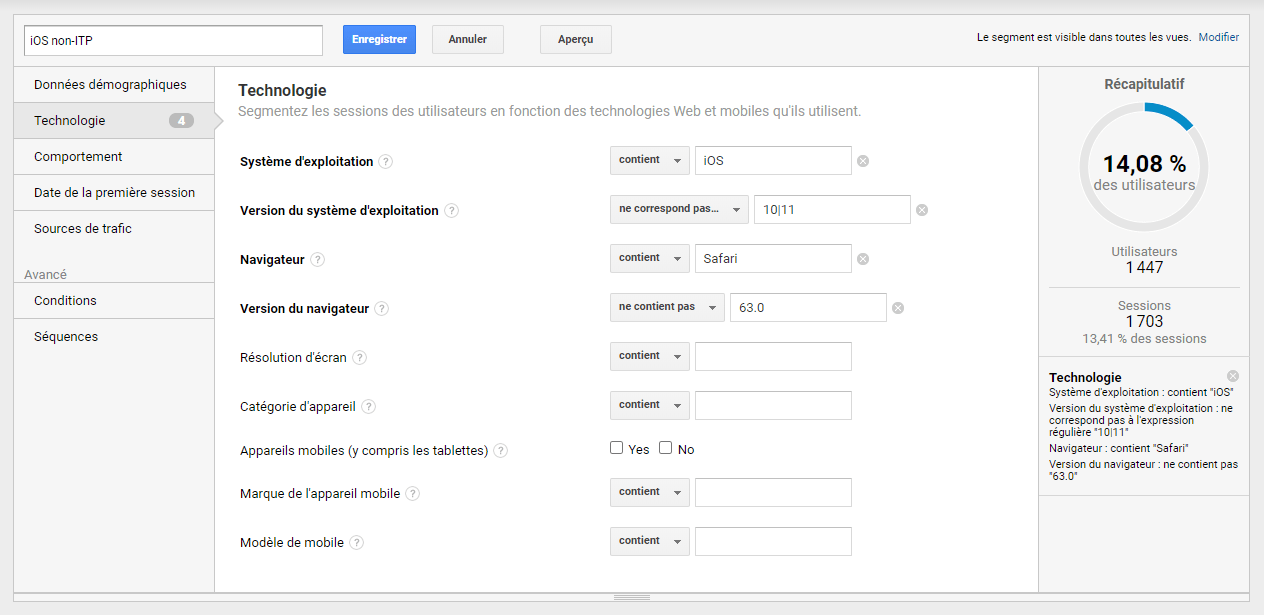

Prenons l’exemple suivant : nous avons créé des segments pour iOS avec ITP et iOS sans ITP :

Segment avancé pour iOS ITP

Segment avancé pour iOS sans ITP

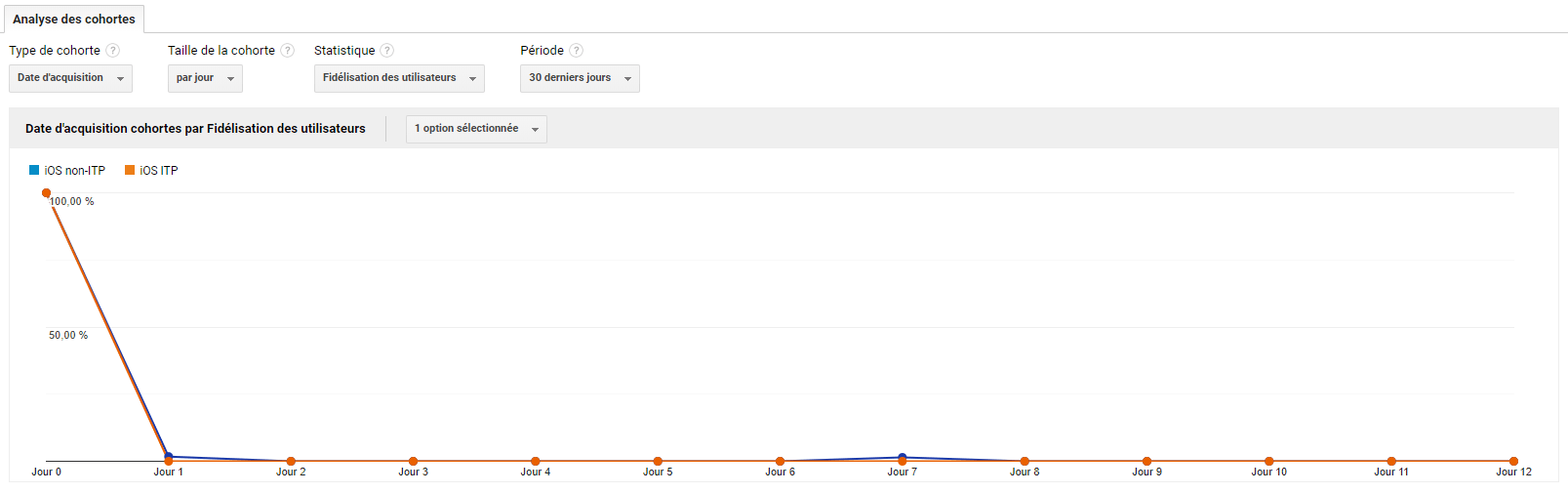

Une fois que vous les avez mis en place, comparez les deux segments dans la section Analyse de cohorte. Bien que cela puisse être le résultat d’une variété d’autres facteurs comportementaux, nous constatons jusqu’à présent que l’ITP ne fonctionne pas complètement comme prévu. Pour les sites pour lesquels nous avons fait ces comparaisons, nous constatons que les données sur les utilisateurs ne vont pas complètement à zéro après le septième jour.

Au contraire, nous constatons que la cohorte ITP se rapproche de zéro beaucoup plus rapidement que les non-ITP.

Sachez que vous pouvez faire de même pour les MacOs 10.3 et 10.4 et pour Firefox 63+.

Annotez vos analyses pour les dates de publication

Annotez vos analyses avec les dates de sortie de l’ITP et restez au courant de la sortie de Blink LazyLoad. Les dates de publication de l’ITP sont les suivantes :

2.2 – 4/24/2019

2.1 – 2/21/2019

2.0 – 6/4/2018

1.1 – 3/14/2018

1.0 – 6/5/2017

Consultez les notes de version de Chrome pour découvrir et annoter vos rapports d’affichage, de re ciblage et de programmation lorsque Blink LazyLoad est en service. Garder une trace de ces dates peut vous aider à identifier quand vous avez été frappé par des anomalies de données.

Pour conclure…

Pour Apple, l’ITP est une arme silencieuse pour une guerre silencieuse de la « vie privée ». Tout comme l’introduction par Google de la fonction « not provided », interprétons-le comme un mécanisme permettant de mettre un frein aux activités des entreprises qui s’appuient sur ces données.

Néanmoins, ce n’est que la dernière d’une série de mesures prises par les entreprises et les gouvernements qui entravent la capacité du marketing digital à comprendre et à cibler leur public. Il n’y a aucun moyen d’empêcher la prochaine datapocalypse, mais il est bon d’être conscient de son impact.

Pour les spécialistes du marketing digital, la plus grande crainte devrait être de voir ce marketing se transformer en un gâchis incommensurable. Alors que les plateformes s’acharnent sur notre sort, c’est le bon moment pour repenser ce que vous collectez. Et ainsi la façon d’inciter les utilisateurs à se connecter et à rester connectés.

GUIDE GRATUIT

Prévision et anticipation du Retour Sur

Investissement pour le référencement naturel (SEO)

Catégories

- Agence web (24)

- Analytics (23)

- Anticiper le post Covid19 (4)

- Blog (167)

- E-commerce (3)

- IA (6)

- Inbound Marketing (31)

- Marketing automation (15)

- Marketing de contenu (11)

- News (17)

- Online marketing (19)

- Rapidité d’exécution en période de crise (2)

- RGPD (3)

- Saisir les opportunités du moment et rester actif (4)

- SEA (5)

- SEO (98)

- SEO et ROI (6)

- Social Media (20)

- Web Marketing B2B (24)